这是一个创建于 337 天前的主题,其中的信息可能已经有所发展或是发生改变。

问题:

我有一个 Django 项目和一个 PHP 项目,用于提供 电子节目单( EPG ) 服务,每天大约 30 万次 API 请求。服务器配置较低,只有 4G 内存。我需要在 数据库( MySQL 、PostgreSQL ) 和 缓存( Redis 、Memcached ) 方面进行优化,以提高 API 响应速度并减少资源占用。

具体问题如下:

- 数据库选择:在 MySQL 和 PostgreSQL 之间,哪种更适合小内存环境?

- 数据库优化:如何设置 连接数、缓存、索引策略 以减少内存占用并提高查询效率?

- 缓存方案:Redis 和 Memcached 在 EPG API 场景下,哪种更合适?如何高效缓存查询结果?

- 具体配置建议:对于 低内存服务器,推荐哪些数据库和缓存配置参数?

示例场景:

- API 主要用于查询电视节目信息,比如:

/api/v1/epg?channel=CCTV1&date=2025-03-15 - 数据更新频率较低,每天 5-6 次,查询请求远多于写入请求

- 目前数据库存储有 数万条节目单数据,查询主要基于 频道 + 日期

希望大家能分享一些 小内存服务器优化 API 处理能力 的经验!谢谢!

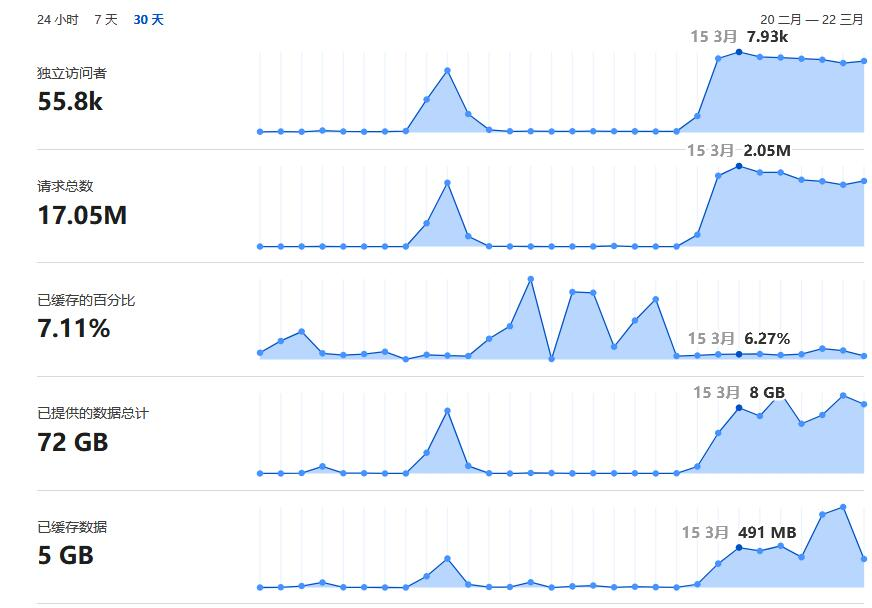

第 1 条附言 · 2025 年 3 月 22 日

将网站放到Cloudflare上一周左右,表现如下

看了下大家的建议,有让直接静态json处理的,有让SQlite数据库的,均尝试过,效果不怎么好。SQlite请求量一上去就直接锁库。静态JSON处理CPU接近100%。

使用MySQL,无任何优化,Linux下负载 12.42 / 16.93 / 14.85 ,不应该这么高才对。

倒是内存无太大影响

空闲内存:236 MB

已用:898 MB

总内存:3914 MB

共享:16 MB

可分配内存:2729MB

buff/cache:2780/0 MB

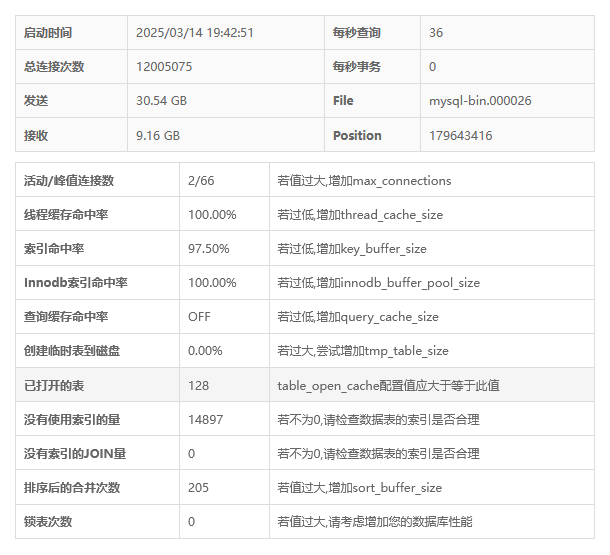

今天下午去查看,使用MySQL数据库搭配宝塔面板进行直观检测,配置如下,CPU100%爆红。

已确认是MySQL占用CPU。

1

502Chef 2025 年 3 月 15 日

按照 12 小时计算,平均 rps 也只有 7 左右,考虑到高峰期翻倍,14 的并发不是一个小内存缓存就解决了吗

|

2

jinlong 2025 年 3 月 15 日

1H1G 的阿里云突发 ECS+Redis+MySQL ,曾经跑过一天超千万的 click 用户数据统计+分析,你服务器内存都 4G 了,so easy ,核心问题是把数据库独立出去,程序本身没任何问题,做好缓存优化,比如提前把大量数据缓存到 redis 里。

|

3

javalaw2010 2025 年 3 月 15 日 如果本身数据量是有限的,那么你这个场景很适合静态化,将数据直接定时生成为 json ,然后 nginx 层配置一下对应接口按规则 rewrite 到对应的 json 文件即可。

|

4

huskyui 2025 年 3 月 15 日

看看有没有 localcache 的组件,反正是单机,直接用 localcache ,用 lru 方式设定一个 max memory

|

5

Victor215 2025 年 3 月 15 日

4G 内存不小了,如果数据量不大,直接缓存到程序内存里就行,redis 反而作用不大。

|

6

imNull 2025 年 3 月 15 日 这种场景 数据库直接用 sqlite 就行了吧

|

7

sagaxu 2025 年 3 月 15 日 30 万次,QPS 峰值 30 左右,且都是读。如果是高性能 SSD ,redis/memcached 都可以省了,就这么点量还配了 4G 内存,技术上没犯错根本不用优化。

|

8

jiuhuicinv 2025 年 3 月 15 日

下云,放家里

|

9

sparkssssssss 2025 年 3 月 15 日

nginx 直接缓存在内存就完事了,后面 redis 做数据存储,防止缓存击穿.三十万洒洒水,

|

10

000sitereg 2025 年 3 月 15 日

4G 不小了。数据库也放在上面也够用。

30W 也不多。 非要优化 还是用 go 或者 C++重写下,反正业务很简单。 省下来的内存丢给 PG ,别用 mysql 了 |

11

esee 2025 年 3 月 15 日

4G 不算小了。,

|

12

goodryb 2025 年 3 月 15 日

不如 redis 直接开启持久化省事,数据库都省了

|

13

wowbaby 2025 年 3 月 15 日

少折腾的话 mysql + redis ,在程序中做缓存依赖,第一次读走 mysql 然后缓存到 redis 并打上缓存标签,在没有写入数据时都是走 redis ,如果更新了数据,把缓存标签做失效处理,再读的时候又会缓存新的数据。

|

14

itechify PRO cdn

|

15

LLaMA2 2025 年 3 月 15 日

```

http { # 定义 channel 和 date 的组合映射 map "$arg_channel:$arg_date" $file_path { default /path/to/default.json; # 默认文件 "CCTV1:2025-03-15" /path/to/epg/CCTV1/2025-03-15.json; "CCTV2:2025-03-15" /path/to/epg/CCTV2/2025-03-15.json; "CCTV3:2025-03-15" /path/to/epg/CCTV3/2025-03-15.json; # 添加更多映射规则 } server { listen 80; server_name example.com; location /api/v1/epg { # 根据映射的文件路径返回静态文件 try_files $file_path =404; } } } ``` 数据库,redis 都没了,全特么静态文件 自己写个工具生成 json 和 更新 nginx conf 并重启 nginx 就可以了。这样的 4G 内存服务器还能再降本增效! 无聊一说,不必当真 |

16

LLaMA2 2025 年 3 月 15 日

|

17

LLaMA2 2025 年 3 月 15 日

server {

listen 80; server_name example.com; location /api/v1/epg { # 检查 channel 和 date 参数是否存在 if ($arg_channel = "") { return 400 "Missing channel parameter"; } if ($arg_date = "") { return 400 "Missing date parameter"; } # 动态生成文件路径 rewrite ^/api/v1/epg$ /path/to/epg/$arg_channel/$arg_date.json break; # 返回静态文件 try_files $uri =404; } } |

18

tomczhen 2025 年 3 月 15 日

搞这么多组件不如搞成静态化。弄一堆技术不如直接加钱升级服务器。

|

19

SethShi 2025 年 3 月 15 日 1. PostgreSQL 肯定更适合小内存, 毋容置疑, 如果对 MySQL 没有依赖, 直接换

2. 连接数这个没有答案, 监控+压测得到一个合理的值, 自己去看 SQL 缓存命中率(数据库层面) 优化你的 SQL 3. 现在用 Memcached 的已经很少了, 想要内存缓存, 直接在代码层面加二级内存缓存 4. 如果更新不大, 我的建议你直接推送到 CDN, 或者把接口缓存成静态文件直接暴露出去访问 |

20

hefish 2025 年 3 月 15 日

加钱,加 cpu ,加内存。

|

21

IDAEngine 2025 年 3 月 15 日

PostgreSQL + Kvrocks

|

22

Vegetable 2025 年 3 月 15 日

这场景想不到为什么要优化呢,缓存都有点多余其实。几万条数据全量缓存都没多大,Django 也不吃多少内存。

|

23

Outshine 2025 年 3 月 15 日

我觉得你的场景 `sqlite` 都行,然后直接做静态化,定时生成更新静态文件即可

|

24

zoharSoul 2025 年 3 月 15 日

30 万次无需任何优化

mysql 随便抗 |

25

caola 2025 年 3 月 15 日

我一直都在使用 redis 替代品 kvrocks ,可以说是硬盘版 redis , 缓存无压力

|

26

sunpj 2025 年 3 月 15 日

哈哈 乍一看 30w qps 感觉难度还挺大的 后面发现是 30w 一天 直接数据库就没啥压力 mysql 或者 pgsql 都可以 只要没有代码没啥问题 数据库不太可能成为瓶颈的 用不到 redis

|

27

naeco 2025 年 3 月 15 日

无压力

|

28

ferstar 2025 年 3 月 15 日

你这根本毫无压力好吧

1. db 建议无脑 PostgreSQL 2. 没有什么是 explain analyze 解决不了的 3. Redis 足够了,Django 2.0 以后也支持了协程,你把所有同步方法改写成异步,阻塞任务丢 Celery 4. host 内核版本升到 6.13.x ,最近合入了一个大佬关于 swap 的优化,性能暴增 400%,开上 4~8GB 的 swapfile ,bbrv3 也开起来,抗压能力嗖嗖的 |

29

gyinbj 2025 年 3 月 15 日

先上 cdn 再静态化 再上 redis

|

30

abccccabc 2025 年 3 月 15 日

楼主,php 敢不敢用 8.4 的?敢不敢用它的扩展 APCu ,缓存数据放 apcu ,反正是单机跑。根据我的感观,php8.1 比 php7.4 快多了。8.4 比 8.1 又要快一些。

我汇集了一条龙优化方案:参考下: http://biji.sebcxy.com/forum.php?mod=viewthread&tid=268&extra=page%3D1 。 各位高手:如果我写的方案有错误或者某些点还可以再优化的话,可以 @我。我补充或修改一下 |

31

murmurkerman 2025 年 3 月 15 日 via iPhone

哈哈哈,真担心性能要用 redis+go ,https://eieio.games/blog/scaling-one-million-checkboxes/

|

32

raptor 2025 年 3 月 16 日

我还以为是 1G 以下的内存,都 4G 了不算小。特别是以读为主的情况,更新又不多的,加个 redis 就是了,控制一下 redis 的内存用量就好,比如过期时间设置得短点,只缓存最热的数据等。内存占用的话,个人体会是 pg 会小一些,我在 256M 的机器上正常使用过 PG ,但是 mysql 小于 512M 基本没法用。

|

33

bronyakaka 2025 年 3 月 16 日

单机你这场景可能不需要 redis ,直接进程内缓存读写,最最快

|

34

mayli 2025 年 3 月 16 日

直接 sqlite 应该最快,

》 目前数据库存储有 数万条节目单数据,查询主要基于 频道 + 日期 要是只有数万的话,sqlite ,或者直接放内存也够。 小内存一般来说,数据不多,直接放内存也是够的。 数据量大的话,比如 10m 行以下,sqlite+索引也够,你这 epg 明显是可以做个索引完事。 |

35

crackidz 2025 年 3 月 16 日

只要不是大量瞬时动态请求,这请求量也并不高

|

36

pony2335 2025 年 3 月 16 日

异步数据批量落盘,能用内存的就内存 不行就 redis 、最后才是数据库操作,这么干的话,一天随便 30 万

|

37

Ipsum 2025 年 3 月 16 日

顶多加个 redis 缓存,对每次查询做缓存,ttl 差不多 6H 。先从 redis 读,如果没有就从数据库读然后写入缓存。写的话直接写数据库或者先写 redis 然后异步数据库,但是每天就更新几次,建议直接写数据库。4G 内存不小了。

|

38

seansong 2025 年 3 月 16 日

你这个访问量和配置,其实只要不写有问题的逻辑代码在里面,一般正常水准的代码,应该不需要优化技巧,就能跑吧

|

39

securityCoding 2025 年 3 月 16 日 via Android

lru 就行

|

40

FgHh07ObvBiST5po 2025 年 3 月 16 日

我以为你每分钟 30 万次呢... 算了

|

41

Martin123123 2025 年 3 月 16 日

定时任务直接落盘 /data/频道/日期.json nginx 直接读,但是这种需求要不直接考虑定时 push oss + cdn 吧

|

42

jorneyr 2025 年 3 月 16 日

什么语言框架这么废,这么点流量需要优化?

|

43

daimaosix 2025 年 3 月 17 日

别骂了别骂了

|

44

keakon 2025 年 3 月 17 日

用 SQLite 吧,我的笔记本上一秒 40 万次随机查询,比 Redis 还快。

|

46

mxdyeah OP @seth19960929 感谢感谢

|

48

xbin 2025 年 3 月 29 日

按道理不可能性能这么差的,可以提供一份过期的历史数据来测试吗?

|

49

mxdyeah OP |