V2EX › Firefox

firefox 有个开源的本地大模型 https://future.mozilla.org/blog/introducing-llamafile/,什么样的机器能跑动

mrfox · 2023-12-29 08:53:15 +08:00 · 2583 次点击这是一个创建于 459 天前的主题,其中的信息可能已经有所发展或是发生改变。

小主机行吗

1

qping 2023-12-29 09:03:20 +08:00

没说要什么样的机器,但是说了 Supported OSes and CPUs 和 GPU support

https://github.com/Mozilla-Ocho/llamafile 要不你下了试试? |

2

godmiracle 2023-12-29 09:09:40 +08:00

我用 m1 就能跑起来。x86 的好像不行,没跑成功

|

3

qping 2023-12-29 09:19:58 +08:00

amd 7950x 可以跑,还挺顺畅的

有意思 |

5

bfdh 2023-12-29 09:59:44 +08:00

i7-12700 Linux 可以跑

|

6

Seanfuck 2023-12-29 10:15:09 +08:00

貌似是可以直接运行的文件:

AMD64 微处理器必须具有 SSSE3 。否则 llamafile 将打印一个错误并拒绝运行。这意味着,如果你有一个英特尔 CPU ,它需要是英特尔酷睿或更高版本(大约 2006 年以上),如果你有一个 AMD CPU ,那么它需要是推土机或更高版本(大约 2011 年以上)。如果你有一个较新的 AVX CPU ,或者更好的 AVX2 ,那么 llamafile 将利用你的芯片组特性去更快。目前还不支持 AVX512+运行时调度。 话说支持中文吗? |

7

weilongs 2023-12-29 10:42:43 +08:00

两周前看到这个跑过一下,我用的 MacBook pro 2019 款哪个 intel 的本子跑了一下,提出一个问题风扇就起飞了。体验感觉还不错,我体验了 LLaVA 1.5 和 Mistral 7b 。

|

8

jifengg 2023-12-29 10:52:24 +08:00

有意思,去体验一下

|

9

titan2022 2023-12-29 10:58:04 +08:00

4800H 也能跑,速度不算快 有中文

|

10

paopjian 2023-12-29 12:44:21 +08:00

用默认模型跑起来崩溃,用 Mistral 试了试,真不错啊,速度也有

|

12

zsh2517 2023-12-29 14:08:17 +08:00

NAS 上下完了一个模型,先试了试,可能 D1851 太老了,而且这种活可能本来也不适合 CPU 跑。速度感觉一般,而且没有 stream 模式。晚上拿台式机试试

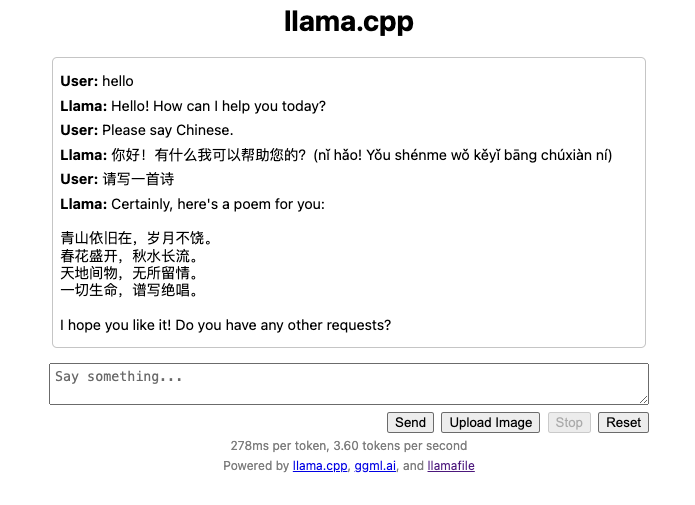

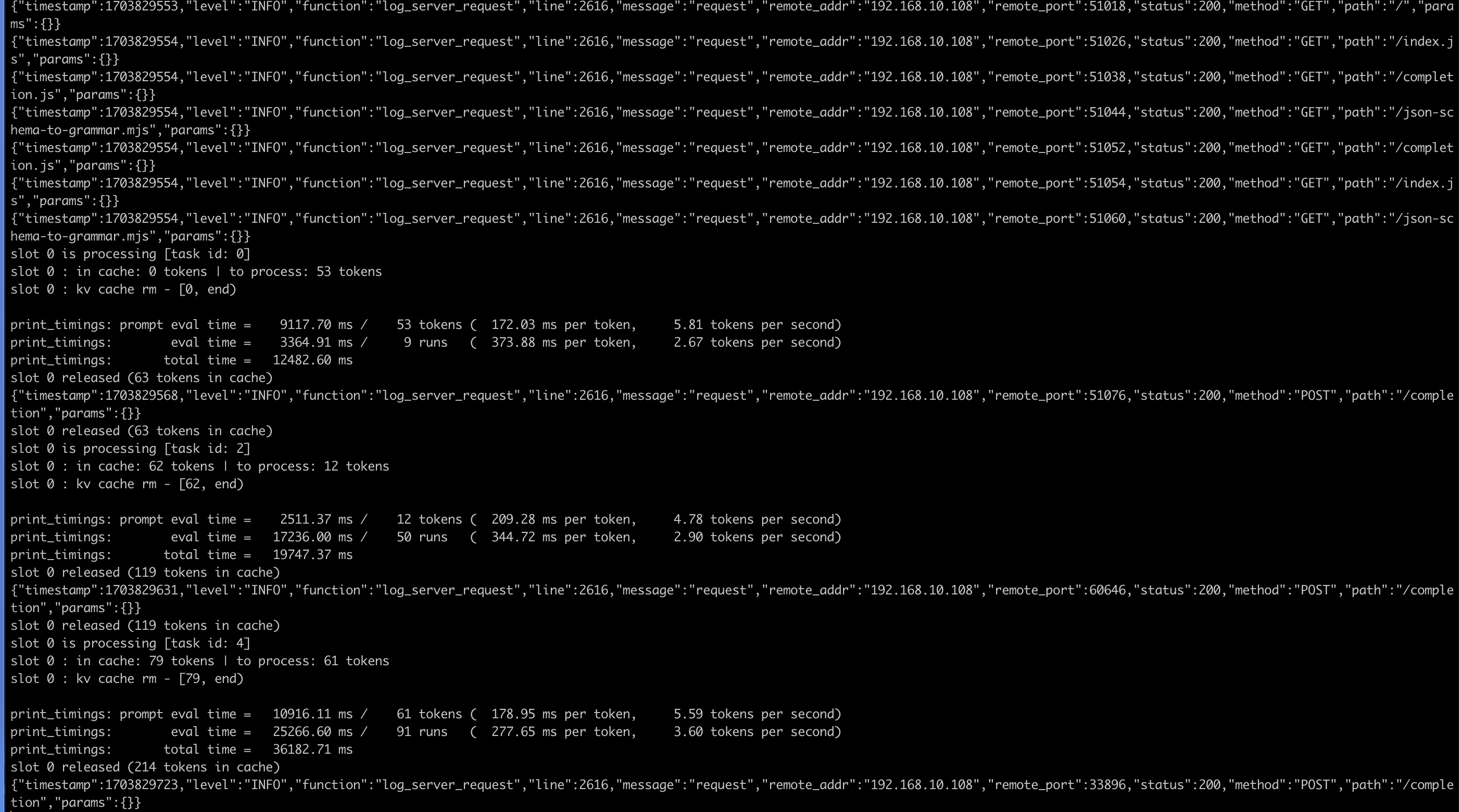

--- 对话截图 =>  控制台截图 =>  宿主环境 D-1581 32 核 64G ,pve LXC 容器 运行参数 ./llava-v1.5-7b-q4-server.llamafile --host 0.0.0.0 --port 1234 --threads 32 |

14

elonlo 2023-12-29 14:41:21 +08:00

我 windows 都跑起来了。i5-13500H

|

15

NoOneNoBody 2023-12-29 14:44:54 +08:00

|

16

Rache1 2023-12-29 15:50:49 +08:00

速度还行,就是不知道为啥,有时候会卡住 😂

|

17

iold 2023-12-29 16:15:24 +08:00

|